AI技术栈分析:从硬件到智能的演进

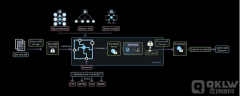

在AI(人工智能)范围,技术栈的复杂性与进步速度密切有关。人工智能技术栈由硬件和软件层次构成,支撑着现代人工智能的各项应用。本文将深入分析这类技术层次,并说明它们在人工智能开发和达成中有哪些用途。大家还将审视这类技术怎么样影响数字货币与人工智能交叉范围的机会,特别是去中心化物理基础设施(DePIN)项目,如GPU互联网。

1. 硬件层:硅的力量

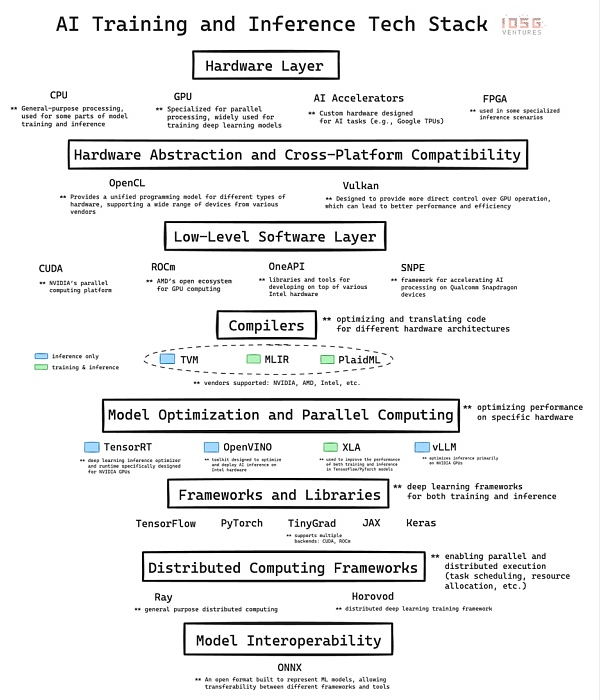

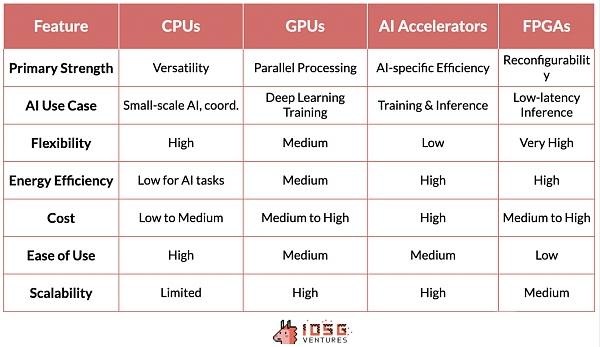

硬件是人工智能技术栈的基础,为AI提供了必需的计算能力。主要组件包含:

CPU(中央处置器):基础计算单元,善于处置序列任务,对数据预处置和小规模人工智能任务至关要紧。GPU(图形处置器):虽刚开始设计用于图形渲染,但其强大的并行计算能力使其成为人工智能练习的核心。这种能力对于现代深度学习模型至关要紧。人工智能加速器:为人工智能工作负载特别设计的芯片,优化了练习和推理任务的性能。FPGA(可编程阵列逻辑):以其可重编程特质,为特定人工智能任务提供灵活性,特别合适低延迟的推理场景。2. 底层软件:中间件的桥梁

底层软件连接了高级人工智能框架与硬件之间的桥梁,重点技术包含:

CUDA:NVIDIA的专有技术,构建了强大的人工智能生态系统,其优化库和工具被广泛用,巩固了NVIDIA在人工智能范围的领导地位。ROCm、OneAPI和SNPE:这类技术进一步增强了高级框架与特定硬件构造的整理,提高了性能。CUDA的主导地位不只由于其技术优势,还因其打造了深厚的软件生态系统,这致使人工智能开发职员和研究职员的工作愈加高效。

3. 编译器:优化和翻译

编译器在技术栈中饰演了优化人工智能工作负载的要紧角色,主要包含:

TVM:提供端到端的优化步骤,致使推理任务能在各种硬件上无缝运行。MLIR:谷歌的项目,简化了编译器基础设施,旨在统一多种抽象级别的表示。PlaidML:专注于跨多种硬件构造的可移植性,力求在各类计算平台上达成人工智能工作的无缝运行。这类编译器为不同硬件平台上的人工智能工作负载优化提供了多元化的解决方法,但现在尚未完全成熟,CUDA依旧维持领先地位。

4. 分布式计算:大规模协调

分布式计算在大规模人工智能应用中至关要紧,主要包含:

Ray:由UC Berkeley开发,提供了灵活的分布式计算框架,适用于强化学习和其他复杂任务。Horovod:由Uber设计,专注于深度学习的分布式达成,优化了多GPU和多服务器节点上的练习过程。这两种办法各有优势,但现在的分布式计算框架仍需进一步进步,以支持更复杂的分布式人工智能应用。

5. 展望将来:人工智能与数字货币的交汇

在数字货币范围,目前的GPU互联网标志着向更复杂分布式人工智能基础设施的迈进。然而,这类平台尚未完全支持大规模的分布式练习。将来的分布式计算框架,如Yotta和NeuroMesh,正致力于解决这一挑战。GenSyn也在开发一套通用的编译器,旨在扩展去中心化人工智能计算互联网的能力。

Hyperbolic的解决方法通过借助广泛的硬件配置,达成了高效的推理能力,预示着人工智能计算的将来可能变得愈加分布式和高效。这类新兴技术的成功将取决于它们怎么样与现有人工智能工作步骤无缝集成,并解决实质应用中的问题。

上一篇:网络计算机击败 以太币 和 ADA,成为重点指标第一

下一篇:没有了

免责声明:

1.本文内容综合整理自互联网,观点仅代表作者本人,不代表本站立场。

2.资讯内容不构成投资建议,投资者应独立决策并自行承担风险。